들어가며: 또 다른 AI 도구? 아니, 이번엔 다르다

솔직히 말해서, 처음엔 저도 “또 AI 도구 하나 나왔구나” 했습니다.

LangChain, AutoGPT, CrewAI…

이미 시장에는 AI 에이전트 프레임워크가 넘쳐나죠.

그런데 Sim Studio를 써보고 나서 생각이 완전히 바뀌었어요.

제가 평소에 개발하면서 가장 불편했던게,

간단한 자동화 하나 만들려고 해도 보일러플레이트 코드를 수십 줄씩 써야 한다는 거였어요.

API 호출하고, 에러 처리하고, 로깅하고…

정작 핵심 로직은 몇 줄 안 되는데 말이죠.

그러던 중 우연히 Hacker News에서 Sim Studio를 발견했는데,

“드래그 앤 드롭으로 AI 워크플로우를 만든다”는 문구가 눈에 띄더라고요.

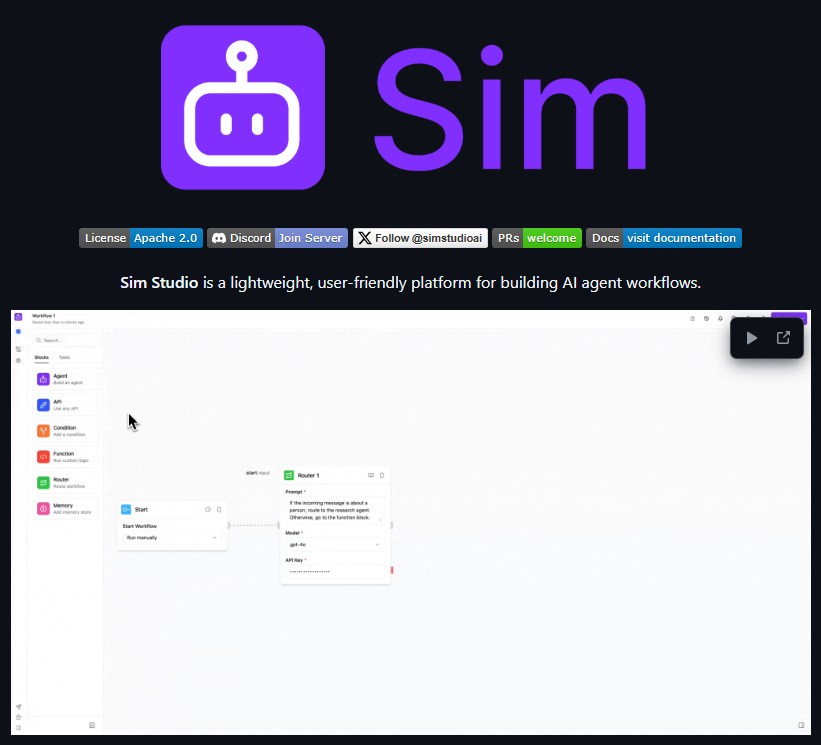

Sim Studio가 뭐길래?

NOTE[한 줄 요약]

AI 에이전트 워크플로우를 시각적으로 만들 수 있는 오픈소스 플랫폼

쉽게 말해서, n8n이나 Zapier 같은 워크플로우 도구인데

AI 에이전트에 특화된 버전이라고 보시면 돼요.

근데 여기서 끝이 아니에요.

제가 Sim Studio를 쓰면서

”와, 이거 진짜 잘 만들었다” 싶었던 부분들:

1. 진짜 “AI-Native” 설계

보통 기존 도구들은 전통적인 개발 환경에

AI 기능을 억지로 끼워 넣은 느낌이 강해요.

반면 Sim Studio는 처음부터 AI 워크플로우를 위해

설계됐다는 게 느껴집니다.

예를 들어, 프롬프트 테스팅이나 모델 파라미터 조정같은 게 너무 자연스러워요.

“아, 개발자가 실제로 AI 에이전트 만들어보면서 필요한 게

뭔지 알고 만들었구나” 라는게 느껴졌는데, 나만의 필링..

2. 로컬 우선 접근

이거 정말 중요한데요, 대부분의 AI 플랫폼들이 클라우드 API만 지원하는 반면,

Sim Studio는 Ollama를 통한 로컬 모델 실행을 완벽 지원합니다.

제가 한 달에 OpenAI API로 쓰는 비용이 200달러 넘어가던 시절이 있었는데,

Ollama로 로컬 모델 돌리니까 비용이 0달러예요.

물론 성능 차이는 있지만, 개발이나 테스트 단계에서는 충분하더라고요.

특히 mvp 빨리 만들고 싶을때 乃

3. 실시간 디버깅

이건 진짜 신기했어요.

워크플로우가 실행되는 걸 실시간으로 볼 수 있고,

각 단계에서 어떤 데이터가 오가는지 다 보여줍니다.

예전에 LangChain으로 개발할 때는 print문 도배하면서

디버깅했던 기억이…ㄷㄷㄷ

설치하기: 생각보다 쉽지만 몇 가지 함정.

자, 이제 실제로 설치해봅시다. 공식 문서대로 하면 5분이면 끝난다고 하는데

음, 제 경험상 30분-50분은 잡으셔야 해요.

(첫 번째 함정: 항상 공식 문서의 예상 시간에 6을 곱하세요)

사전 준비물

먼저 이것들이 설치되어 있어야 합니다:

- Docker & Docker Compose (필수!)

- Git

- 텍스트 에디터 (VS Code 추천)

WARNING[Windows 사용자 주의!]

Windows에서는 WSL2를 먼저 설정하세요

Docker Desktop만 깔면 된다고 생각하시면 큰 오산입니다.

WSL2 없이 Docker Desktop만으로는 제대로 작동 안 할 수 있어요.

macOS 설치 가이드

# 1. 저장소 클론

git clone https://github.com/simstudioai/sim.git

cd sim

# 2. 환경 변수 설정

cp sim/.env.example sim/.env여기서 첫 번째 삽질 포인트! .env 파일을 꼭 편집하세요:

# .env 파일 열기

nano sim/.env # 또는 좋아하는 에디터 사용

# 이 두 개는 필수로 설정해야 함

BETTER_AUTH_SECRET=아무거나32자이상의랜덤문자열넣으세요진짜아무거나됩니다

DATABASE_URL=postgres://postgres:postgres@db:5432/simstudioTIP[Pro Tip]

BETTER_AUTH_SECRET 생성하기 귀찮으시죠? 터미널에서 이렇게 하세요openssl rand -base64 32

이제 Docker Compose로 실행

# 3. Docker로 실행

docker compose up -d --build

# 처음 실행시 이미지 빌드 때문에 5-10분 걸립니다

# 커피 한 잔 하고 오세요 ☕Windows 설치 가이드

Windows는 조금 더 복잡합니다. (언제나 그렇듯!)

# PowerShell을 관리자 권한으로 실행

# 1. WSL2 설치 (이미 있으면 스킵)

wsl --install

# 2. Docker Desktop 설치 후 WSL2 백엔드 활성화 확인

# Docker Desktop 설정 > General > Use WSL 2 based engine 체크

# 3. WSL2 Ubuntu 터미널에서 실행

wsl

# 이후는 macOS와 동일

git clone https://github.com/simstudioai/sim.git

cd sim

cp sim/.env.example sim/.envCAUTION[Windows 특별 주의사항]

Windows에서 가장 많이 겪는 문제:

- 파일 권한 문제 → WSL2 내에서 작업하세요

- 포트 충돌 → 3000번 포트 사용 중인지 확인

- Docker 메모리 부족 → Docker Desktop에서 메모리 4GB 이상 할당

설치 확인

설치가 끝났으면 브라우저에서 http://localhost:3000/w/ 접속해보세요.

IMPORTANT[URL 주의!]

/w/를 빼먹지 마세요!

그냥localhost:3000으로 가면 404 뜹니다.

저도 처음에 이거 때문에 10분 헤맸어요

첫 번째 워크플로우: “Hello, AI Agent!”

자, 이제 재미있는 부분입니다! 첫 워크플로우를 만들어봅시다.

Step 1: 기본 구조 이해하기

Sim Studio의 워크플로우는 “블록”들로 구성됩니다.

각 블록은 특정 작업을 수행하고,

블록들을 연결해서 전체 워크플로우를 만드는 거죠.

주요 블록 타입:

- Input Block: 워크플로우의 시작점

- LLM Block: AI 모델 호출

- Tool Block: 외부 도구나 API 호출

- Output Block: 결과 반환

Step 2: 간단한 코드 리뷰 봇 만들기

개발자라면 누구나 한 번쯤 “PR 리뷰 자동화하면 좋겠다”고 생각해보셨을 거예요.

간단한 버전을 만들어봅시다!

-

새 워크플로우 생성

- 왼쪽 사이드바에서 “New Workflow” 클릭

- 이름은 “Code Review Bot”으로

-

Input Block 추가

- 드래그 앤 드롭으로 Input Block 추가

- 설정에서 입력 스키마 정의:

{ \"code\": \"string\", \"language\": \"string\", \"context\": \"string\" } -

LLM Block 추가 및 연결

- LLM Block을 추가하고 Input Block과 연결

- 프롬프트 설정:

You are an experienced code reviewer. Review the following {{language}} code:{{code}}

Context: {{context}} Provide constructive feedback focusing on: 1. Code quality and best practices 2. Potential bugs or issues 3. Performance improvements 4. Security concerns ```과 연결 - 프롬프트 설정:You are an experienced code reviewer. Review the following {{language}} code:

{{code}}Context: {{context}}

Provide constructive feedback focusing on:

- Code quality and best practices

- Potential bugs or issues

- Performance improvements

- Security concerns

여기서 제가 발견한 꿀팁!

프롬프트에서 {{변수명}} 형식으로 이전 블록의 출력을 참조할 수 있어요.

처음엔 이게 어색했는데, 익숙해지니까 오히려 직관적이더라고요.

Step 3: GitHub API 연동하기

이제 좀 더 실용적으로 만들어봅시다.

GitHub PR에서 자동으로 코드를 가져와서 리뷰하는 기능을 추가할 거예요.

-

HTTP Request Block 추가

URL: https://api.github.com/repos/{{owner}}/{{repo}}/pulls/{{pr_number}}/files Method: GET Headers: Authorization: Bearer {{github_token}} -

Transform Block으로 데이터 가공

// PR 파일 중에서 실제 코드 부분만 추출 return data.map(file => ({ filename: file.filename, patch: file.patch, status: file.status })).filter(file => file.status !== 'removed');

이 부분에서 삽질 경험담: GitHub API는 파일별로 patch 형태로 diff를 주는데,

전체 파일 내용이 필요하면 별도 API 호출이 필요해요.

로컬 LLM 연동: 비용 절감의 마법

자, 로컬 LLM 연동하기!

Ollama 설치 및 설정

먼저 Ollama를 설치해야 합니다:

macOS:

# Homebrew로 설치

brew install ollama

# 또는 공식 인스톨러 사용

curl -fsSL https://ollama.com/install.sh | shWindows (WSL2):

# WSL2 Ubuntu에서 실행

curl -fsSL https://ollama.com/install.sh | sh모델 다운로드

# 코딩에 특화된 모델들

ollama pull codellama:7b # 가벼운 코드 생성 모델

ollama pull mistral:7b # 범용 모델 (한국어도 어느정도 가능)

ollama pull deepseek-coder:6.7b # 코딩 특화 모델

# 모델 실행 확인

ollama run mistral:7bTIP[모델 선택 가이드] 제가 여러 모델 써본 결과:

- 가벼운 작업: mistral:7b (속도 빠름, 품질 괜찮음)

- 코드 생성: codellama:7b 또는 deepseek-coder

- 한국어 필요: gemma2:9b (한국어 성능 준수)

- 고품질 필요: llama3:70b (RAM 64GB 이상 필요!)

Sim Studio에 Ollama 연결

이게 진짜 쉬워요. Docker Compose 실행할 때 프로필만 추가하면 됩니다:

# GPU 있는 경우

docker compose --profile local-gpu up -d --build

# GPU 없는 경우 (CPU only)

docker compose --profile local-cpu up -d --build근데 여기서 함정!

이미 호스트에서 Ollama를 실행 중이라면:

# 방법 1: host 네트워크 사용

docker compose up --profile local-cpu -d --build --network=host

# 방법 2: docker-compose.yml 수정

# extra_hosts 추가하는 방법 (위 설치 가이드 참조)저는 처음에 이거 몰라서 “왜 연결이 안 되지?” 하면서 2시간 헤맸네요.. 😅

실전 프로젝트 1: PR 자동 리뷰 시스템

이제 진짜 써먹을 만한 걸 만들어봅시다.

실제로 제가 쓰고 있는 PR 자동 리뷰 시스템이에요.

전체 아키텍처

GitHub Webhook → Sim Studio Workflow → Review Comment 작성

↓

Code Analysis

↓

LLM Review

↓

Format & Post상세 구현

-

Webhook 받기

# Webhook Block 설정 Path: /webhooks/github-pr Method: POST Secret: {{GITHUB_WEBHOOK_SECRET}} -

PR 정보 파싱

// Transform Block const pr = data.pull_request; return { pr_number: pr.number, title: pr.title, description: pr.body, author: pr.user.login, files_url: pr.url + '/files', comments_url: pr.comments_url }; -

파일별 분석 (반복문)

여기가 좀 트리키한데,

Sim Studio는 아직 네이티브 반복문을 지원하지 않아요. 그래서 이렇게 우회

// 모든 파일을 하나의 문자열로 합치기

const reviewRequests = files.map(file => ({

filename: file.filename,

language: getLanguageFromExtension(file.filename),

patch: file.patch

}));

// 배치로 처리

return JSON.stringify(reviewRequests);-

LLM 리뷰 생성

Review the following code changes: {{batch_data}} For each file, provide: 1. Overall assessment (Good/Needs Work/Critical) 2. Specific line-by-line comments 3. Suggestions for improvement Format as JSON for easy parsing. -

GitHub에 댓글 작성

// HTTP Request Block으로 댓글 POST const comments = JSON.parse(llm_output); // 각 파일별로 인라인 코멘트 작성 for (const comment of comments) { await postReviewComment({ path: comment.filename, line: comment.line, body: comment.message }); }

실제 사용 후기

장점:

- 주니어 개발자들이 놓치기 쉬운 부분을 잘 잡아냅니다

- 코드 스타일 일관성이 확실히 좋아졌어요

- 새벽에 올라온 PR도 바로 피드백이 가능

단점:

- 가끔 과도하게 세세한 지적을 할 때가 있어요

- 비즈니스 로직은 이해 못 함 (당연하지만…)

- 대용량 PR은 토큰 제한 때문에 분할 처리 필요

NOTE[비용 절감 팁]

OpenAI API 대신 로컬 Mistral 모델 사용하니 월 0

대신 서버 비용은 있지만, 이미 있는 서버 활용하면 추가 비용 없음!

실전 프로젝트 2: API 모니터링 & 알림 시스템

두 번째 프로젝트는 API 헬스체크와 장애 알림 시스템입니다.

요구사항

- 5분마다 주요 API 엔드포인트 체크

- 응답 시간이 느리거나 에러 발생시 알림

- 장애 패턴 분석 및 리포트

구현

-

스케줄러 설정

# Scheduler Block Cron: */5 * * * * # 5분마다 Timezone: Asia/Seoul -

멀티 API 체크

// 체크할 API 목록 const apis = [ { name: 'User API', url: 'https://api.myapp.com/users/health' }, { name: 'Payment API', url: 'https://api.myapp.com/payments/health' }, { name: 'Auth API', url: 'https://api.myapp.com/auth/health' } ]; // 병렬로 체크 (Transform Block) const results = await Promise.all( apis.map(async (api) => { const start = Date.now(); try { const response = await fetch(api.url); const latency = Date.now() - start; return { ...api, status: response.status, latency, healthy: response.status === 200 && latency < 1000 }; } catch (error) { return { ...api, status: 0, latency: -1, healthy: false, error: error.message }; } }) ); -

이상 감지 및 알림

// Condition Block const unhealthyAPIs = results.filter(api => !api.healthy); if (unhealthyAPIs.length > 0) { // Slack 알림 전송 return { should_alert: true, message: generateAlertMessage(unhealthyAPIs) }; } -

AI 분석 추가

여기가 재미있는 부분! 단순 알림만 하는 게 아니라 AI가 패턴을 분석하게 했어요:

Analyze the following API health check results from the past hour: {{historical_data}} Current failure: {{current_failure}} Provide: 1. Root cause analysis 2. Is this part of a pattern? 3. Recommended actions 4. Severity level (1-5)

운영 노하우

이거 운영하면서 배운 것들:

-

False Positive 줄이기

- 단발성 타임아웃은 무시 (3회 연속 실패시만 알림)

- 새벽 시간대는 임계값 완화

- 정기 점검 시간은 체크 비활성화

-

컨텍스트 추가

// 최근 배포 정보 함께 전달 const recentDeployments = await getRecentDeployments(); if (recentDeployments.length > 0) { context.possibleCause = \"Recent deployment detected\"; context.deploymentInfo = recentDeployments[0]; } -

점진적 알림

- 1차: Slack 알림

- 2차 (5분 후): 담당자 멘션

- 3차 (10분 후): 전화 알림 (Twilio 연동)

트러블슈팅: 제가 겪은 삽질들

1. Docker 메모리 부족

증상: 워크플로우 실행 중 갑자기 멈춤

해결:

# Docker Desktop 설정에서 메모리 늘리기

# Mac: Preferences > Resources > Memory: 8GB 이상

# Windows: Settings > Resources > Memory: 8GB 이상2. Ollama 모델 로딩 실패

증상: “model not found” 에러

해결:

# 모델이 실제로 다운로드되었는지 확인

ollama list

# 모델 다시 다운로드

ollama pull mistral:7b

# Ollama 서비스 재시작

sudo systemctl restart ollama # Linux

brew services restart ollama # macOS3. Webhook이 안 들어올 때

증상: GitHub에서 webhook 보냈는데 Sim Studio가 못 받음

해결:

-

ngrok으로 로컬 터널링

ngrok http 3000 -

또는 Cloudflare Tunnel 사용 (더 안정적)

cloudflared tunnel --url http://localhost:3000

4. LLM 응답이 너무 느릴 때

이건 정말 흔한 문제인데요, 해결 방법들:

-

스트리밍 활성화

# LLM Block 설정에서 Stream: true -

타임아웃 설정

Timeout: 30s # 기본값이 너무 길어요 -

모델 다운그레이드

- 70B → 13B → 7B 순으로 테스트

- 대부분의 경우 7B로도 충분

5. 한글 깨짐 문제

증상: API 응답이나 로그에서 한글이 ???로 표시

해결:

# docker-compose.yml에 추가

environment:

- LANG=C.UTF-8

- LC_ALL=C.UTF-8성능 최적화 팁

1. 캐싱 활용하기

반복되는 API 호출이나 LLM 응답은 캐싱하세요:

// Cache Block 사용

const cacheKey = `api_response_${endpoint}_${JSON.stringify(params)}`;

const cached = await cache.get(cacheKey);

if (cached) {

return cached;

}

// 캐시 미스인 경우만 실제 호출

const response = await fetch(endpoint, params);

await cache.set(cacheKey, response, { ttl: 3600 }); // 1시간2. 배치 처리

여러 개의 작업을 하나씩 처리하지 말고:

// 나쁜 예

for (const item of items) {

await processItem(item); // 순차 처리

}

// 좋은 예

const batchSize = 10;

const batches = chunk(items, batchSize);

for (const batch of batches) {

await Promise.all(

batch.map(item => processItem(item)) // 병렬 처리

);

}3. 프롬프트 최적화

LLM 비용의 80%는 프롬프트 길이에서 나옵니다:

// 나쁜 예: 매번 전체 컨텍스트 전달

const prompt = `

Here is the entire codebase:

${entireCodebase} // 10만 토큰...

Review this function:

${targetFunction}

`;

// 좋은 예: 필요한 부분만

const prompt = `

Review this function:

${targetFunction}

Related context:

${relevantImports}

${relevantTypes}

`;고급 팁: 커스텀 블록 만들기

제가 자주 쓰는 작업들을 위해 커스텀 블록을 만들었는데요, 생각보다 쉬워요!

예제: Jira 티켓 생성 블록

// custom-blocks/jira-ticket.js

export const JiraTicketBlock = {

type: 'jira-ticket',

name: 'Create Jira Ticket',

category: 'integrations',

inputs: {

title: { type: 'string', required: true },

description: { type: 'string', required: true },

priority: {

type: 'select',

options: ['Low', 'Medium', 'High', 'Critical'],

default: 'Medium'

},

assignee: { type: 'string' }

},

async execute(inputs, context) {

const { title, description, priority, assignee } = inputs;

try {

const response = await fetch('https://your-domain.atlassian.net/rest/api/3/issue', {

method: 'POST',

headers: {

'Authorization': `Basic ${btoa(`${context.env.JIRA_EMAIL}:${context.env.JIRA_API_TOKEN}`)}`,

'Content-Type': 'application/json'

},

body: JSON.stringify({

fields: {

project: { key: 'PROJ' },

summary: title,

description: {

type: 'doc',

version: 1,

content: [{

type: 'paragraph',

content: [{ type: 'text', text: description }]

}]

},

priority: { name: priority },

assignee: assignee ? { name: assignee } : null

}

})

});

const result = await response.json();

return {

ticketId: result.key,

url: `https://your-domain.atlassian.net/browse/${result.key}`

};

} catch (error) {

throw new Error(`Failed to create Jira ticket: ${error.message}`);

}

}

};이런 커스텀 블록을 만들어두면 반복 작업이 정말 편해져요. 특히 내부 시스템과 연동할 때 유용합니다.

실전 팁: 프로덕션 운영 경험

1. 환경 분리

개발/스테이징/프로덕션 환경을 분리하세요:

# docker-compose.prod.yml

version: '3.8'

services:

simstudio:

environment:

- NODE_ENV=production

- LOG_LEVEL=info

- RATE_LIMIT_ENABLED=true

deploy:

replicas: 2

resources:

limits:

cpus: '2'

memory: 4G2. 모니터링 설정

프로덕션에서는 모니터링이 필수예요:

// monitoring/prometheus-exporter.js

const prometheus = require('prom-client');

// 워크플로우 실행 메트릭

const workflowExecutions = new prometheus.Counter({

name: 'simstudio_workflow_executions_total',

help: 'Total number of workflow executions',

labelNames: ['workflow_name', 'status']

});

// 실행 시간 히스토그램

const executionDuration = new prometheus.Histogram({

name: 'simstudio_workflow_duration_seconds',

help: 'Workflow execution duration in seconds',

labelNames: ['workflow_name'],

buckets: [0.1, 0.5, 1, 2, 5, 10, 30, 60]

});3. 백업 전략

워크플로우와 데이터베이스 백업은 필수:

#!/bin/bash

# backup.sh

# 데이터베이스 백업

docker compose exec -T db pg_dump -U postgres simstudio > "backups/db_$(date +%Y%m%d_%H%M%S).sql"

# 워크플로우 파일 백업

tar -czf "backups/workflows_$(date +%Y%m%d_%H%M%S).tar.gz" ./workflows/

# S3로 업로드 (선택사항)

aws s3 cp backups/ s3://your-backup-bucket/simstudio/ --recursive자주 묻는 질문 (FAQ)

제가 커뮤니티에서 자주 받는 질문들을 정리했어요

Q1: Sim Studio vs LangChain, 뭐가 다른가요?

A: LangChain은 코드 기반 프레임워크고, Sim Studio는 시각적 워크플로우 빌더예요.

- LangChain: 개발자가 직접 코딩, 세밀한 제어 가능

- Sim Studio: 드래그 앤 드롭, 빠른 프로토타이핑, 비개발자도 사용 가능

저는 프로토타입은 Sim Studio로 만들고, 복잡한 로직이 필요하면 LangChain으로 마이그레이션해요.

Q2: 대용량 파일 처리는 어떻게 하나요?

A: 스트리밍과 청크 처리를 활용하세요:

// Transform Block에서 대용량 CSV 처리

const stream = fs.createReadStream(filePath);

const parser = csv.parse({ columns: true });

let batch = [];

const BATCH_SIZE = 1000;

stream.pipe(parser)

.on('data', (row) => {

batch.push(row);

if (batch.length >= BATCH_SIZE) {

processBatch(batch);

batch = [];

}

})

.on('end', () => {

if (batch.length > 0) {

processBatch(batch);

}

});Q3: 보안은 어떻게 관리하나요?

A: 몇 가지 기본 원칙:

- API 키는 환경 변수로 관리

- 워크플로우 실행 권한 관리 (RBAC)

- 네트워크 격리 (VPC 내부 운영)

- 정기적인 보안 업데이트

# .env.production

ENCRYPT_SECRETS=true

SECRET_KEY=${SECRET_KEY}

ALLOWED_IPS=10.0.0.0/8,172.16.0.0/12Q4: 성능이 느려질 때는?

A: 제가 겪은 성능 문제들과 해결법:

-

데이터베이스 인덱싱

CREATE INDEX idx_workflow_executions_created ON workflow_executions(created_at DESC); -

Redis 캐싱 추가

const redis = require('redis'); const client = redis.createClient(); // 자주 사용하는 데이터 캐싱 const getCachedData = async (key) => { const cached = await client.get(key); if (cached) return JSON.parse(cached); const data = await fetchFromDB(key); await client.setex(key, 3600, JSON.stringify(data)); return data; }; -

워크플로우 최적화

- 불필요한 블록 제거

- 병렬 처리 가능한 부분 분리

- 조건부 실행으로 불필요한 작업 스킵

마무리: 사용 후기

Sim Studio를 3개월간 실전에서 사용해본 솔직한 후기입니다.

좋았던 점

-

진입 장벽이 낮음

- 비개발자 분들도 간단한 워크플로우는 직접 만들더라고요

- “코드 몰라도 된다”는 게 진짜였음

-

디버깅이 쉬움

- 시각적으로 어디서 막혔는지 바로 보임

- 각 단계별 입출력 확인 가능

-

확장성

- 커스텀 블록 만들기 쉬움

- 기존 시스템과 통합도 간단

-

비용 효율적

- 로컬 LLM 지원으로 API 비용 대폭 절감

- 오픈소스라 라이선스 비용 없음

아쉬운 점

-

아직 초기 버전

- 가끔 UI 버그가 있어요

- 문서가 부족한 부분들이 있음

-

복잡한 로직 구현의 한계

- 조건문이 복잡해지면 스파게티 됨

- 반복문 지원이 제한적

-

버전 관리

- Git으로 워크플로우 버전 관리가 애매함

- 팀 협업 기능이 부족

추천 대상

- ✅ AI 워크플로우를 빠르게 프로토타이핑하고 싶은 개발자

- ✅ API 비용 부담 없이 AI 자동화를 구축하고 싶은 스타트업

- ✅ 코딩 없이 AI 에이전트를 만들고 싶은 비개발자

- ✅ 기존 n8n/Zapier 사용자 중 AI 기능이 필요한 사람

추천하지 않는 경우

- ❌ 엔터프라이즈급 안정성이 필요한 경우

- ❌ 복잡한 비즈니스 로직이 많은 경우

- ❌ 실시간 고성능 처리가 필요한 경우

GitHub

참고 자료 및 링크

부록: 자주 사용하는 프롬프트 템플릿

제가 자주 쓰는 프롬프트들 공유합니다:

코드 리뷰용

You are a senior developer reviewing code.

Focus on: security, performance, maintainability.

Be constructive and specific.

If the code is good, say so.

Code to review:

{{code}}API 응답 파싱용

Parse the following API response and extract:

{{extraction_requirements}}

Response:

{{api_response}}

Return as valid JSON only, no explanation.에러 분석용

Analyze this error and suggest solutions:

Error: {{error_message}}

Stack trace: {{stack_trace}}

Context: {{context}}

Provide:

1. Root cause

2. Quick fix

3. Long-term solution